Page 22 - BP_202306

P. 22

行训练,自动与手动训练搭配使

用可以让跟踪的结果精度更高。

接着,使用Retargeter将

演员与模型进行绑定,创建角色

控制器模板,使用跟踪的数据驱

动模型。针对项目不同特点,有

两种驱动方式。第一种,对于精

度要求较高的项目,可通过制作

关键帧,并利用关键帧算法的方

式进行数据解算,表情匹配。过

程中可根据美术风格把模型调整

成角色模型应有的表情,使表演

实现美术可控。第二种,对于效

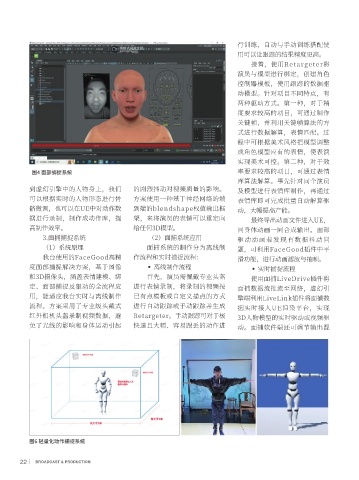

图4 面部捕捉系统 率要求较高的项目,可通过表情

库算法解算。事先针对同个演员

到虚幻引擎中的人物身上,我们 的剧烈抖动对视频质量的影响。 及模型进行表情库制作,再通过

可以根据实时的人物形态进行骨 方案使用一种基于神经网络的端 表情库即可完成批量自动解算驱

骼微调,也可以在UE中对动作数 到端的blendshape权值输出框 动,大幅提高产能。

据进行录制,制作成动作库,提 架,来将演员的表情可以重定向 最终导出动画文件进入UE,

高制作效率。 给任何3D模型。 同身体动画一同合成输出。面部

3.面捕捕捉系统 (2)面捕系统应用 驱动动画若发现有数据抖动问

(1)系统原理 面捕系统的制作分为离线制 题,可利用FaceGood插件中平

我台使用的FaceGood高精 作流程和实时捕捉流程: 滑功能,进行动画滤波与抽帧。

度面部捕捉解决方案,基于图像 ● 离线制作流程 ● 实时捕捉流程

和3D摄像头,涵盖表情建模、绑 首先,演员需佩戴专业头盔 使用面捕LiveDrive插件将

定、面部捕捉及驱动的全流程应 进行表情录制,将录制的视频按 面捕数据流推流至网络,虚幻引

用,能适应我台实时与离线制作 已有点模板或自定义描点的方式 擎端利用LiveLink插件将面捕数

流程。方案采用了专业级头戴式 进行自动跟踪或手动跟踪并生成 据实时接入UE渲染平台,实现

红外相机头盔录制视频数据,避 Retargeter。手动跟踪可对于极 3D人物模型的实时驱动或视频驱

免了光线的影响和身体运动引起 快速且大幅、容易跟丢的动作进 动。面捕软件端还可调节输出混

图6 轻量化动作捕捉系统

22 BROADCAST & PRODUCTION